2023年7月26日

AIと著作権・AIガバナンスについて考える(後編)

国際的なAIガバナンス・現状分析

弁護士 出井甫 (骨董通り法律事務所 for the Arts)

前編では、AIと著作権法上の課題や、それに関する諸外国の対応を概観しました。

また、これからG7サミット等を通じて、国際的なAIガバナンスの実現に向けた議論が進められることもお伝えしました。

今回は、後者の国際的なAIガバナンスについて考えつつ、それを踏まえたAIと著作権の現状を少し分析してみたいと思います。

目次

(前編の続き)

4. AI原則からAIガバナンスへ

5. AIガバナンスの意義

6. リスクベース・アプローチ

7. ガバナンス手法

(1) 行為の4つの制約原理

(2) 共同規制

(3) アジャイル・ガバナンス

8. ガバナンスを踏まえたAIと著作権の現状分析

(1) AI創作物と著作物の混在防止

(2) AIへの学習に伴う著作権者の意思の尊重

(3) 見えてきたこと

9. AIガバナンスの行方

4. AI原則からAIガバナンスへ

これまで、AIに関する国際的なルールは、国際機関やAIステークホルダーなどから、「AI原則」として共有されていました。

例えば、著名なものとして、AI開発に伴うリスク軽減などを目標とする非営利団体「Future of Life Institute(FLI)」が2017年に公表した「アロシマAI原則」(英語版・和訳版)が挙げられます。この原則では、「AIの研究課題」「倫理と価値観」「長期的な課題」の3領域を含むAI利活用のためのガイドラインが示されています。

また、2019 年5月に、42か国が採択した経済協力開発機構(OECD)のAI原則も重要です。このAI原則は、「包摂的な成長、持続可能な開発及び幸福」「人間中心の価値観及び公平性」「透明性及び説明可能性」「頑健性、セキュリティ及び安全性」「アカウンタビリティ」という5つ原則で構成されています*。なお、同年6月に開催されたG20首脳会合では、同原則が首脳宣言の附属文書となり、「G20 AI原則」として合意されています。

*2023年5月、OECDは、ChatGPTなど生成AIの急速な普及を考慮して、AI原則の見直しを検討することを表明しています。

このようなAIに関するグローバルスタンダードは、既に存在しています。

そのため、国際的なAIガバナンスを議論する際には、こうした原則の理念をある程度意識せざるを得ないと考えます。

もっとも、国によっては、独自にAIに関する原則を策定しているところもあります。日本も例外ではく、「AI開発ガイドライン」や「AI利活用ガイドライン」(いずれもAIネットワークス社会推進会議ウェブサイト 参照)、「人間中心のAI 社会原則」などを公表しています。

それ故、各国の独自性と協調性のバランスを、どのように図るかが今後の検討課題となりそうです。

5. AIガバナンスの意義

では改めて、AIガバナンスとは何でしょうか。

「ガバナンス」という語は、一般に、企業統治(コーポレートガバナンス)や国家統治のように、ある組織をコントロールする意味で用いられているように思います。

ただ、2020年8月に経済産業省が主催した「新たなガバナンスモデル検討会」では、ガバナンスを、「社会において生じるリスクをステークホルダーにとって受容可能な水準で管理しつつ、そこからもたらされる正のインパクトを最大化することを目的とする、ステークホルダーによる技術的、組織的、及び社会的システムの設計及び運用」と説明されています(経済産業省「ガバナンスモデルの現状と概要」3頁)。

そして、2022年1月、同じく経済産業省が主催した「AI原則の実践の在り方に関する検討会」では、上記説明を踏まえてAIガバナンスを、

「AI の利活用によって生じるリスクをステークホルダーにとって受容可能な水準で管理しつつ、そこからもたらされる正のインパクトを最大化することを目的とする、ステークホルダーによる技術的、組織的、及び社会的システムの設計及び運用」

と定義しています(経済産業省「AI原則実践のためのガバナンス・ガイドライン ver. 1.1」(2頁注5))。

このように、AIガバナンスにおいては、コントロールの対象が、AIという新興技術である点に特徴があります。当たり前のようですが、重要な視点でしょう。

6. リスクベース・アプローチ

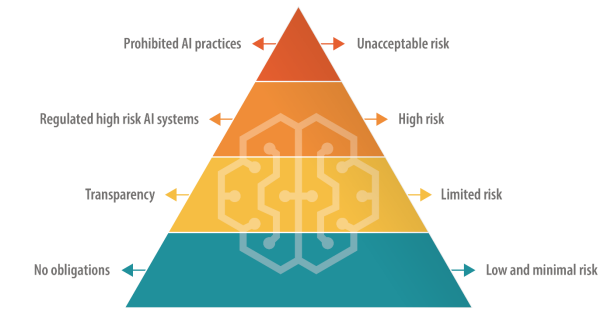

AIガバナンスの設計にあたっては、AIの利活用によって生じるリスクの大きさと規制の程度を対応させる考え方「リスクベース・アプローチ」が、国際的に有効と考えられています。

例えば、2021年に制定されたEUのAI規則では、このアプローチが採用されています。具体的には、AIによるリスクを「許容できないリスク」「高いリスク」「限定的なリスク」「最小限な又はゼロリスク」に分類し、それぞれの分類に対して、「禁止」「原則禁止・厳密な条件で例外的に許容」「透明性確保を条件に許容」「制限なし」という姿勢で規制が設られています(下図参照)。

そして、生成AIの一種である人間と対話するAIシステム(チャットボットなど)や、画像、音声、映像コンテンツを生成または操作するAIシステム(ディープフェイク)は、「限定的なリスク」に分類され、透明性義務の対象とされています(Amendment 486,Article 52 – paragraph 3 – subparagraph 1)。ただ、もちろんAIの利用態様によっては「許容できないリスク」や「高いリスク」に分類される可能性はあります。

リスクベース・アプローチのイメージ

出典:EU「BRIEFING EU Legislation in Progress Artificial intelligence act」

*EU「Regulatory framework proposal on artificial intelligence」も参照

その他、2023年4月、前編で触れた「G7群馬高崎デジタル・技術大臣会合」の閣僚宣言では、「AIの政策と規制は、・・・リスクベースで将来指向でなければならないことを再確認する。」と記されており、リスクベース・アプローチによる取り組みが合意されています(G7デジタル・技術閣僚宣言(45))。

2023年5月には、米国とEUが、信頼できる責任あるAI技術を進歩させるために、リスクベース・アプローチに取り組むことを共同声明として発表しています(U.S. Department of Commerceウェブサイト)。

リスクの分析方法や規制の在り方についても、国家間である程度足並みをそろえることはできそうです。今後、リスクの類型化や基準の統一化がどのように図られるかが注目です。

生成AIに関しては、前記EUのように、全面禁止や無制約という位置づけではなく、「限定的なリスク」(場合によっては「高いリスク))又はそれと同等のレベルに位置づけられるのではないかと予想します。

7. ガバナンス手法

次に、AIの利活用に伴うリスクを受容可能な水準で管理し、正のインパクトを最大化する仕組みは、どのように構築したら良いでしょうか。

参考になるものとして、2020年7月に経済産業省が主催した「Society5.0における新たなガバナンスモデル検討会」による「Society5.0の実現に向けた法とアーキテクチャのリ・デザイン報告書」及び、そのアップデート版である「GOVERNANCE INNOVATION Ver.2: アジャイル・ガバナンスのデザインと実装に向けて報告書」が挙げられます。

これらは、AIを含む新興技術が浸透した社会におけるガバナンスモデルを検討した報告書です。同書では、アメリカ憲法学者Lawrence Lessig教授が提唱した「行為の4つの制約原理」や、官民による「共同規制」、ゴールの設置と改善を繰り返す「アジャイル・ガバナンス」について言及されています。

以下、この3つのガバナンス手法を概観してみます。

*新興技術のガバナンス手法には、本コラムで扱うものの他、ホライゾン・スキャニング、フォーサイト、テクノロジー・アセスメント、規制影響評価(RIA)、規制ギャップ調査などが存在します(松尾・岸本著「新興技術ガバナンスのための政策プロセスにおける手法・アプローチの横断的分析」参照)。

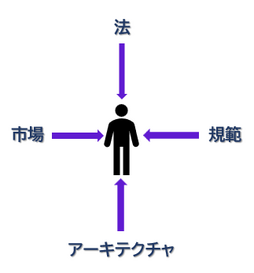

(1) 行為の4つの制約原理

レッシグ教授は、人の行動を規制する手段は主に4つあるといいます(Lawrence Lessig: Code: And Other Laws of Cyberspace, Version 2.0; Basic Books(2006))。

それが、①法、②規範、③市場、④アーキテクチャです。

①法は、公権力による制裁によって行為を制約するもの、②規範(Norms)は、(レッシグの用法においては)確立されたモラルのように周囲の人々の目による制裁を行為の制約として用いるもの、③市場は、経済的インセンティブの変動によって人々の行為を制約するもの、④アーキテクチャは、操作可能な物理環境に基づく制約、いわゆる技術です。

例えば、私たちは、他人の物を盗もうとしても、①窃盗罪によって処罰される、②周りから泥棒と言われて冷遇される、③盗んでも高く買い取ってくれる場所がない、④物が金庫などによって保管されている、といった制約を受けています(下図参照)。

|

►法:窃盗罪を定める ►規範:盗むと泥棒として冷遇される ►アーキテクチャ:物を保管されている ►市場:買い取ってくれない |

AIガバナンスにおいても、リスクの要因となる行動を、どの制約によって規制し、理想の行動に誘導するかを考えるにあたって、この手法は参考になるでしょう。

なお、4つの制約の全てを常に考える必要があるというわけではなく、適当なものが見つからない場合には、その制約のみ、保留又はスキップすることがあっても良いと思います。

また、著作権の分野では、規範が法に事実上優先することがある点には留意が必要です。例えば、ファンアートの一部は権利者の明確な許諾がなくとも社会的に許容されています。一方、理論的には著作権侵害が成立しなくても、権利者へのリスペクトを欠くとみなされた作品は炎上して淘汰されることがあります(この2つの関係に言及したものとして福井弁護士のコラムが参考になります)。

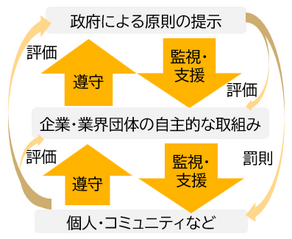

(2) 共同規制

共同規制とは、民間による自主規制を基調としながら、国がそれを支援・補強する連携型のガバナンス手法です。

「規制」と聞くと、つい国がルールの設計から監督・執行までを一手に担うことが当然のように思えそうです。もっとも、現在の技術の進化速度を踏まえると限界があります。日々、ネット上では無数の投稿や意思疎通が行われています。今では仮想空間でのコミュニティも生まれています。これを国が全て管理監督することは困難です。

そうした状況では、国が、規制の大枠を示し、それに基づく民間の自主規制の実効性を監視し、支援・補強する方が効率的といえます。

以下は、国、企業・業界団体、個人・コミュニティに分けて、それぞれの利点と欠点を追記した共同規制のイメージ図です。

|

・政府 権力・執行力⇔時間がかかる ・企業・業界団体 即効性・監視力⇔自社利益がベース ・個人・コミュニティ 世論や文化形成⇔多数派に流される恐れ |

AIガバナンスにおいても、①国が法による制約原理を担い、②規範、③市場、④アーキテクチャの制約原理については、なるべく企業・業界団体、個人・コミュニティが主導しつつ、適宜、国が監視・支援する形が望ましいように思われます。

前編で触れた、英国のAI白書でも同様の見解が述べられています。

(3) アジャイル・ガバナンス

実施された対策は、必ずしも適切に機能し続けるとは限りません。新しい技術や社会情勢の変化によって、人の価値観や行動も変化するからです。

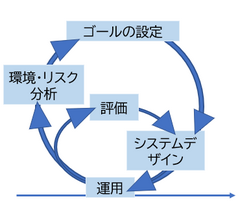

そこで、前記経済産業省の報告書では、「ゴールの設定」、「システムデザイン」、「運用・評価」、「環境・リスク分析」のサイクルを繰り返す、アジャイル・ガバナンスが推奨されています。

アジャイル・ガバナンスでは、PDCAサイクルのPlanの背景にある環境の変化を踏まえて「ゴール」をアップデートしていきます(下図参照)。そうすることで、技術の発展や社会変動に応じた、柔軟かつ迅速なシステムデザインの設計が期待できます。

なお、ここで念頭に置くべきことは、ゴールには階層があることです。

| 例えば、ガバナンスのゴールは、突き詰めると究極的には「幸福や自由」などに辿り着きそうです。ただ、それをゴールに設定しても、漠然としてしまい、対策を具体化しづらくなります。 |

|

そのため、設定するゴールは、ある程度、階層の低いものにしておく方が良さそうです。例えば、「営業秘密の保護」や「顧客情報の漏洩防止」、といったゴールにしておくと、それを達成するシステムデザインも考えやすくなるように思います。

8. ガバナンスを踏まえたAIと著作権の現状分析

やや抽象的な話が続きましたが、試しに上記ガバナンスの考え方を踏まえて、AIと著作権の現状を少し分析してみます。

(1) AI創作物と著作物の混在防止

前編では、AI創作物と著作物との判別ができないことにより、本来、著作権法上の保護の対象ではないAI創作物が、著作物と扱われてしまうリスクを説明しました。

このリスクは、OECD・AI原則のうち、公平公正な社会を実現しようとする「人間中心の価値観及び公平性」の原則の実現を妨げる恐れがあるように思います。

そこで、ここでは「AI創作物と著作物の混在防止」というゴールを設定してみます。

その上で、このゴールを実現するために現在実施されている対策を、行為の4つの制約原理の観点から整理してました。その制約主体は、【】に記載しています。

►法:生成AIを利用していること等の表示【国】

例)中国: インターネット情報サービスにおける新総合成管理規定(17条、18条)

EU: 修正AI規則案

(Amendment 486,Article 52 – paragraph 3 – subparagraph 1)

►アーキテクチャ: ウォーターマークやデジタル透かしの導入【企業】

例)ラディウスファイブ「mimic」、Adobe「Firefly」

►市場: 補助金制度などを活用した技術開発ビジネス 【国、企業】

例)-*

►規範:ガイドライン等による啓発活動【業界団体 / 個人・コミュニティ】

例)ディープラーニング協会による生成AIガイドラインの公表

*個社に対するものですが、2023年7月、経済産業省はソフトバンクに対して、生成AIを開発するために約53億円を提供することを発表しています(関連記事)。

法に関しては中国やEUによるAI事業者に対する規制が、アーキテクチャに関してはAI生成物に自動でウオーターマークやデジタル透かしを付ける技術、規範では、生成AIを活用する方に向けたガイドライン等による啓発活動が挙げられます。厳密には、啓発活動の結果、個人やコミュニティがそのガイドラインを規範として受け入れることによって規範が形成されます。市場に関しては目立った対策は見受けられませんが、AI関連の補助金制度を活用した技術開発ビジネスなどはこれに含まれ得るように思います。

そして、アジャイルガバナンスの観点からは、今後、例えば上記対策が実施されたとしても、表示するための技術を無効化したり、その無効化する機器を普及させるといった、新たな課題が生じてくるかもしれません。その場合には、当該無効化又は普及する行為を防止するゴールの見直しが求められることになりそうです。

(2) AIへの学習に伴う著作権者の意思の尊重

もう少し分析してみます。前編では、著作物が大量に学習されることで、自身の著作物を想起させるAI生成物が普及することへの不安の声があると説明しました。

現在、この課題に関する現行法上の適法性に関する明確な結論はでていません。

ただ、この状況を放置していると、クリエイターの創作活動へのインセンティブが阻害されるリスクがあります。このリスクは、OECD・AI原則のうち、「包摂的な成長、持続可能な開発及び幸福」の原則の遵守に影響が生じそうです。

それ故、ここではあくまで作業仮説として、「AIへの学習に伴う著作権者の意思の合理的な尊重」というゴールを設定してみます。

その上で、現状、このゴールを実現するために実施されている対策のいくつかを、前記同様に整理してみました。

►法:オプトアウト制度【国】

例) EU: DSM指令3条、4条、

参考)日本:著作権法47条の5、同施行令7条の4・1項1号、同施行規則4条の4

►アーキテクチャ: 機械可読プログラム 【企業・業界団体】

例)robots.txt、International Press Telecommunications Council「RightsML」

►市場: 開発資金の提供とそれを踏まえた技術開発 【国 / 企業】

例)―

►規範: 技術標準化に向けた活動【企業・業界団体/ 個人・コミュニティ】

例)Text and Data Mining Reservation Protocol Community Group

法は、オプトアウト制度を導入しているEUのDSM指令が挙げられます。これは、一定の要件のもと、著作物を学習する者は、著作権者から要請があった場合には、学習対象から要請された著作物を除外するというものです(前編「3海外の動向」もご覧下さい)。そうすることで、著作権者は意図しない学習行為を止めることができます。

なお、日本の著作権法にも、オプトアウト制度が存在します。

具体的には、所在検索サービスやその準備*を行う者は、「robots.txt」などの名称の付されたファイルや、HTML又はこれに類する言語で作成されたネット上のファイルに、所在検索サービスやその準備を行う者による収集を禁止することが記載されている場合、これを除外して当該サービス用のデータベース等を構築することが義務づけられています(著作権法施行令7条の4第1項1号ロ、同法施行規則4条の4)。

そのため、仮に日本で、著作物の学習にオプトアウト制度を設けたとしても、著作権法の大きな条文工事は必要ないかもしれません。もっとも、学習を行う開発者の負担が増加し得ますので、導入の是非は慎重に考えなけらればならないでしょう。

*現行著作権法上、著作権者の許諾がなくとも、著作物を利用した所在検索サービス(電子計算機を用いて、検索により求める情報が・・記録された著作物の題号又は著作者名、送信可能化された検索情報に係る送信元識別符号その他の検索情報の特定又は所在に関する情報を検索し、及びその結果を提供すること)やそのための準備(データベースの構築等)が認められています(47条の5第1項1号、同条2項)。

規範とアーキテクチャに関しては、上記オプトアウト制度を実装するためのグループ(Text and Data Mining Reservation Protocol Community Group)が存在し、同グループが公表した規格やそれを踏まえた実装ツール(RightsML)が参考になりそうです。市場に関する具体的な対策は、前記同様見受けられませんでしたが、こうした技術を導入するための資金提供とそれを踏まえた技術開発は、有用と思われます。

上記ではオプトアウト制度を中心に紹介しました。もっとも、学習行為を外部から確認することは困難です。そのため当該制度を採用しても、無断の学習行為を完全に阻止することも容易ではないかもしれません。

一方、権利者の中には、学習行為に伴う対価還元を求める意見も出ています。そのため、オプトアウト制度の実効性や、権利者の意向などによっては、前記ゴールで掲げた内容をもう少し具体化し、「学習行為に伴う著作権者への対価還元」に変更する(アジャイルする)という選択肢もあり得そうです。

(3) 見えてきたこと

このように分析してみると、各対策の有効性は、他の対策によって効果が左右され得ることが伺えます。

例えば、中国やEUのように法で表示義務を課す場合、それを実装する技術がなければ、日々、量産されるAI生成物に表示を付すことは難しいように思います。また、その技術が開発されたとしても、開発できる資金が不足していると一部の企業でしか実装できない可能性があります。

更に、生成AIのユーザーが、その技術の存在や必要性を認識していないと、依然としてAI創作物を著作物と偽る者が登場し、対策があまり実効性を持たなくなります。

そのため、ある対策を実施する際には、他の対策との組み合わせや、それによる効果検証が重要と考えます。

また、上記では、国家間の相違をあまり気にせずに対策を列挙しましたが、国際レベルでは、どこまでこうした対策を統一化するか(例:条約の制定、技術標準化、ガイドラインの策定など)も、吟味が必要になりそうです。

9. AIガバナンスの行方

以上、国際的なAIガバナンスについて書いてきました。

ところで最近、劇場版「PSYCHO-PASS サイコパス PROVIDENCE」を見てきました。

「サイコパス」シリーズでは、2100年代の日本が描かれています。そこでは、AIが、人間の生体反応を計測し、個人の能力や性格をスコア化して管理する巨大監視ネットワーク(シビュラシステム)が採用されています。基本的に、政府はこのネットワークの判断に従っていますが、一方で、法律も存在しており、AIの判断と法律が拮抗するシーンが見られます。

今後、私たちの生活にもAIは益々浸透していくでしょう。その結果、サイコパスで描かれるように、社会を律するプロセスにAIが関わってくることは多いに予想されます。

2100年代の世界がどうなっているかは想像つきませんが、それでも、AIガバナンスは生き続け、人がAIに全面的に依存することなく、「人とAIとの共生」が維持されていることを望みます。

本コラムが、みなさまのAIガバナンスを考えるきっかけになれば幸いです。

以上

■ 弁護士 出井甫のコラム一覧

■ 関連記事

「ファストコンテンツって、悪いのか?

~「良い要約」と「悪い要約」を考えてみる~」

2021年12月28日 弁護士

福井健策(骨董通り法律事務所 for the Arts)「AI時代の知的財産権検討会」中間とりまとめ案で、AI議論を追いかける

2024年5月28日 弁護士 出井甫(骨董通り法律事務所 for the Arts)

法的若しくは専門的なアドバイスを目的とするものではありません。

※文章内容には適宜訂正や追加がおこなわれることがあります。